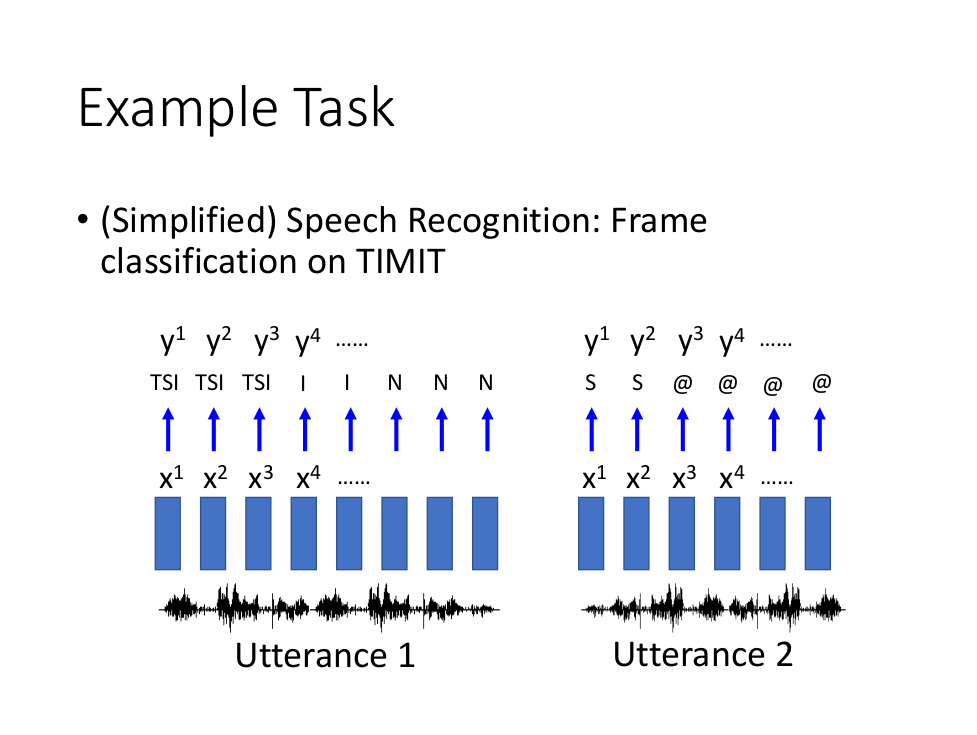

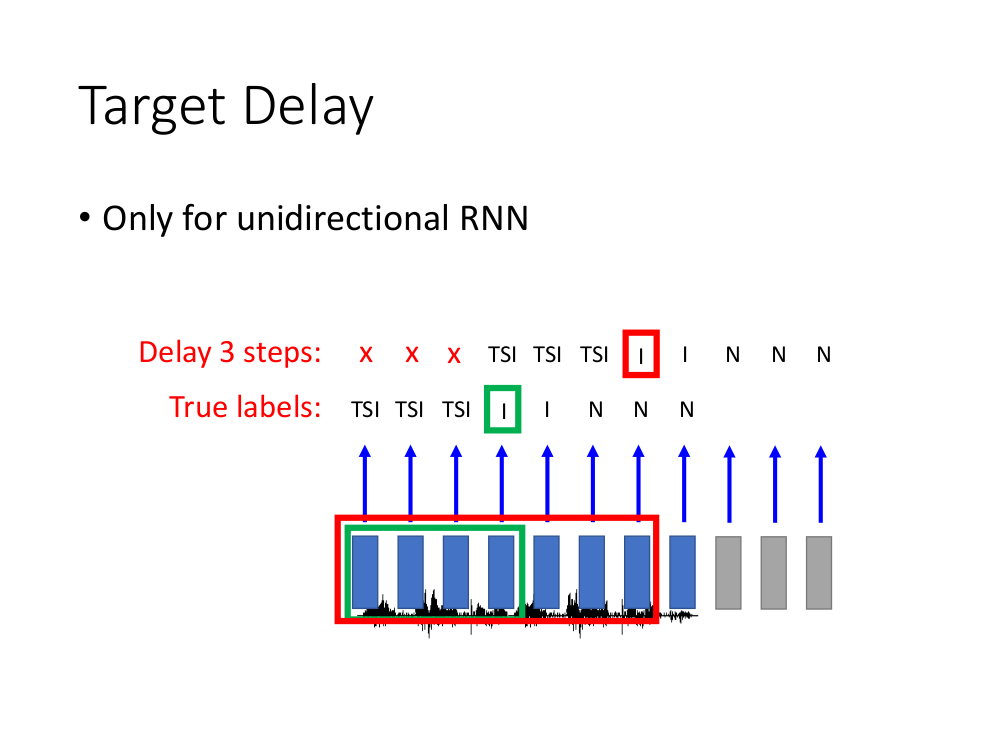

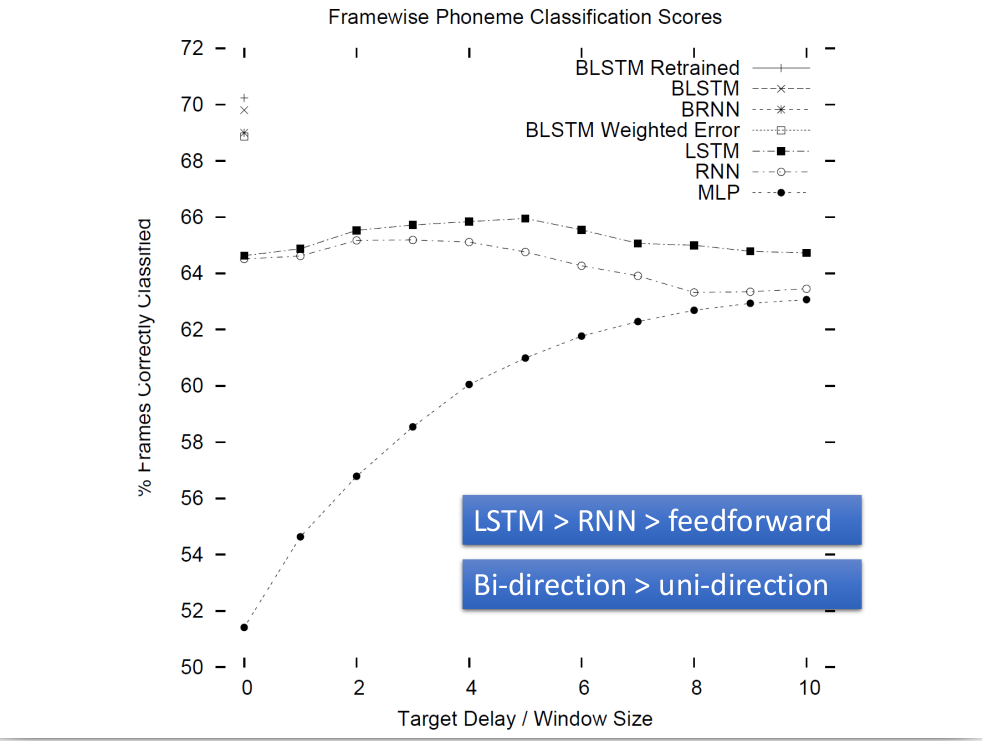

RNN(循环神经网络)

参考链接:RNN

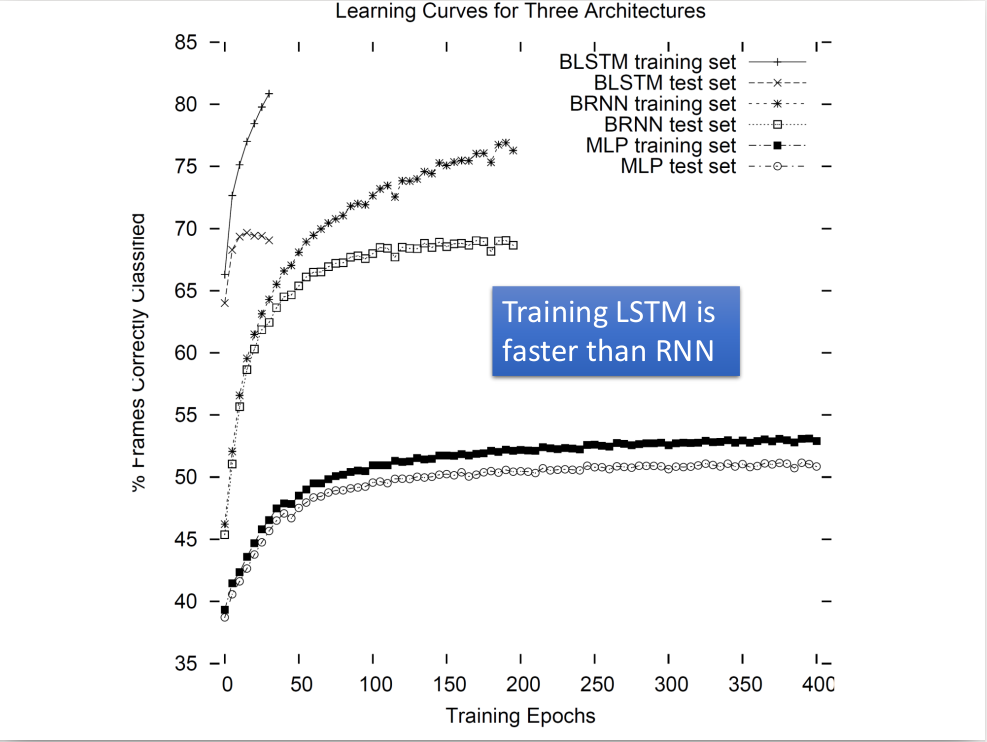

不容易过拟合,比较好的处理sequence.

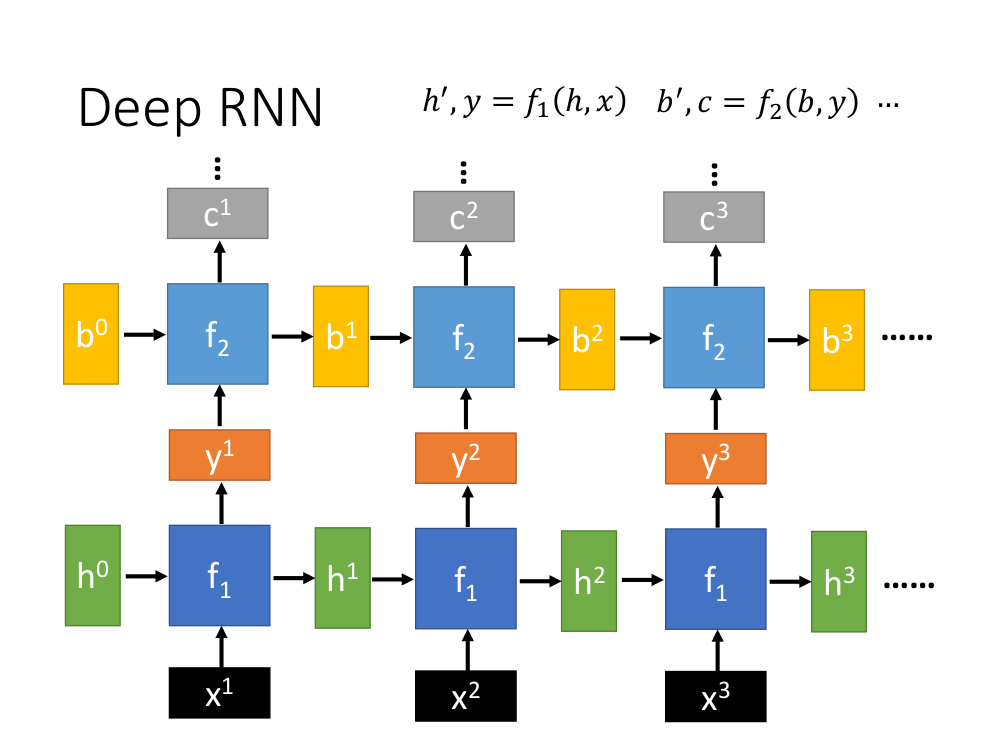

h’与h、b’与b的维度必须都一样。

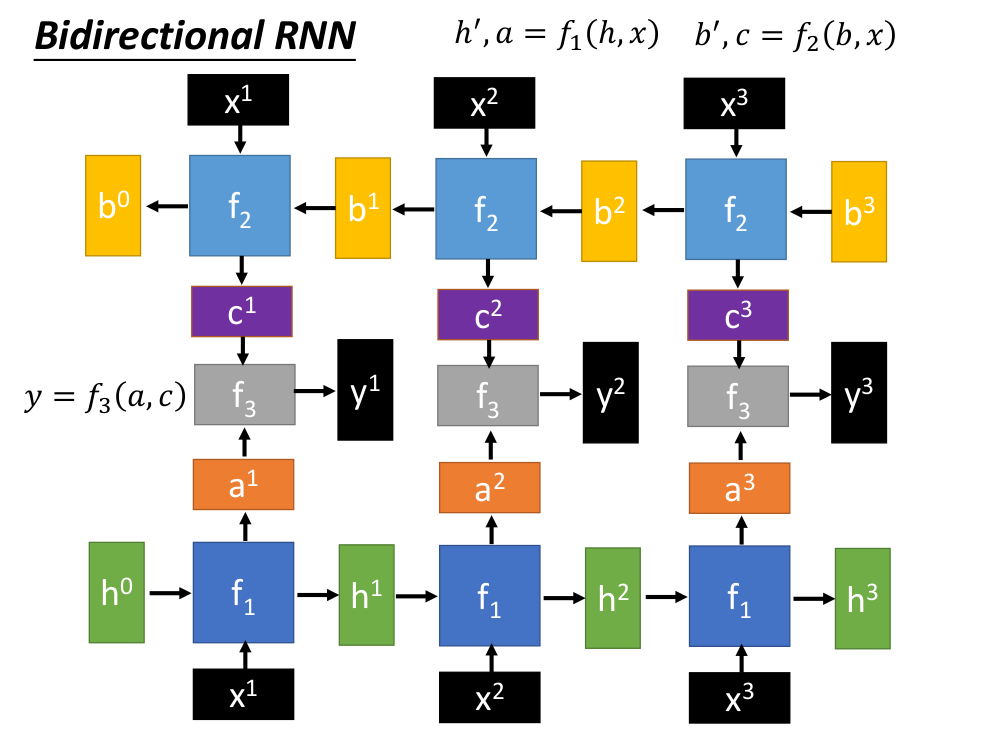

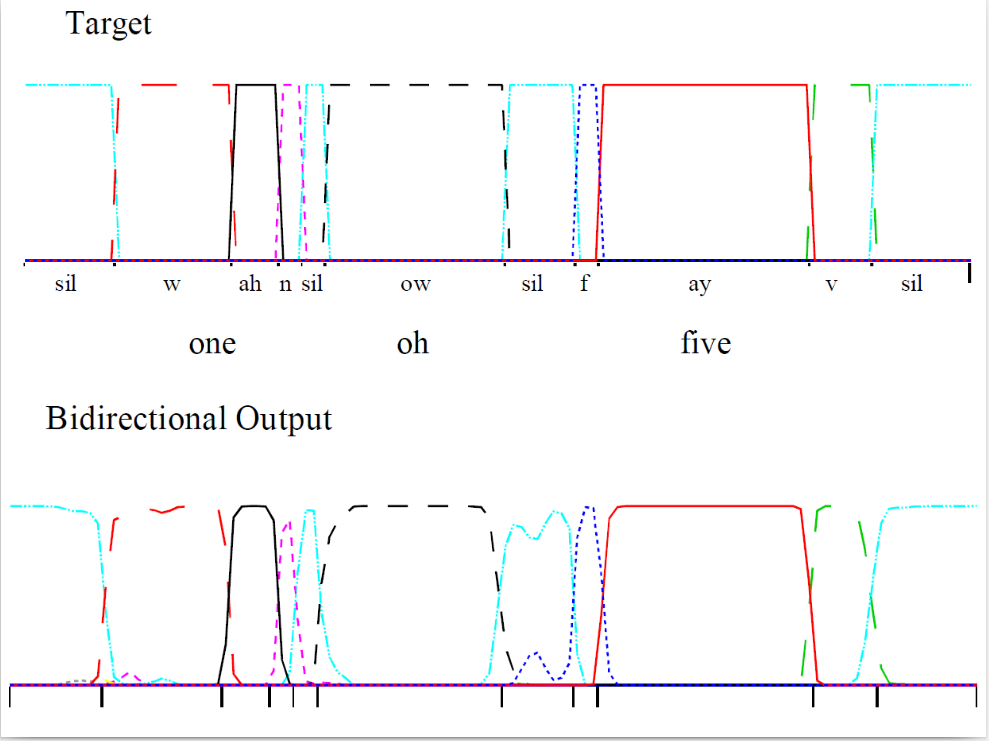

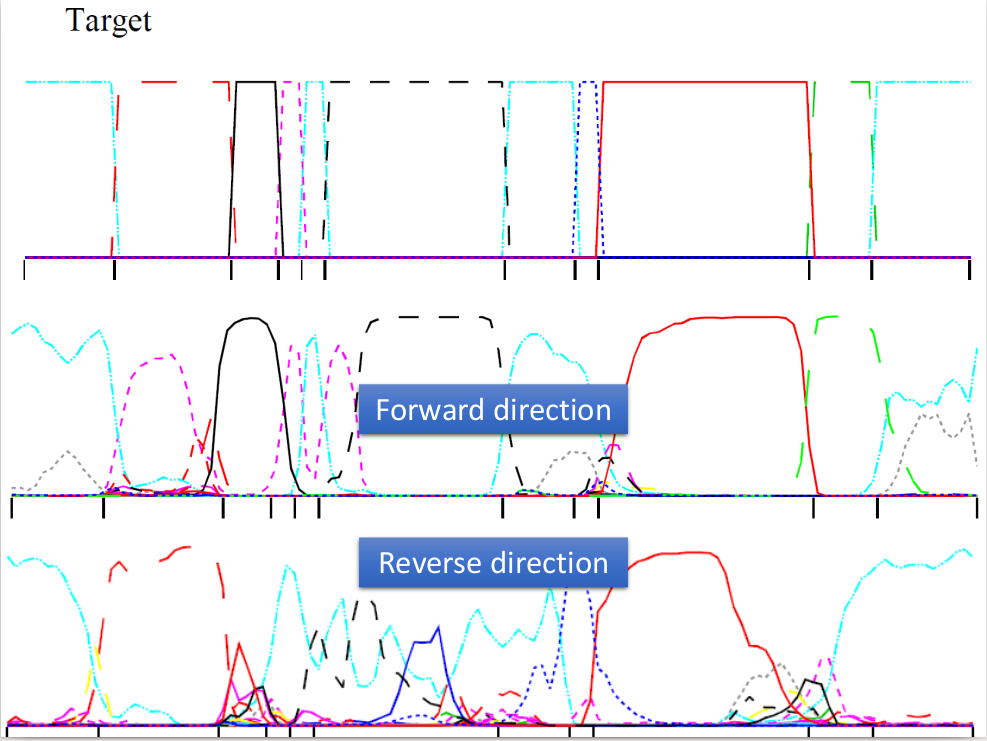

双向RNN,f3存在的目的就是将f1与f2的output合在一起。

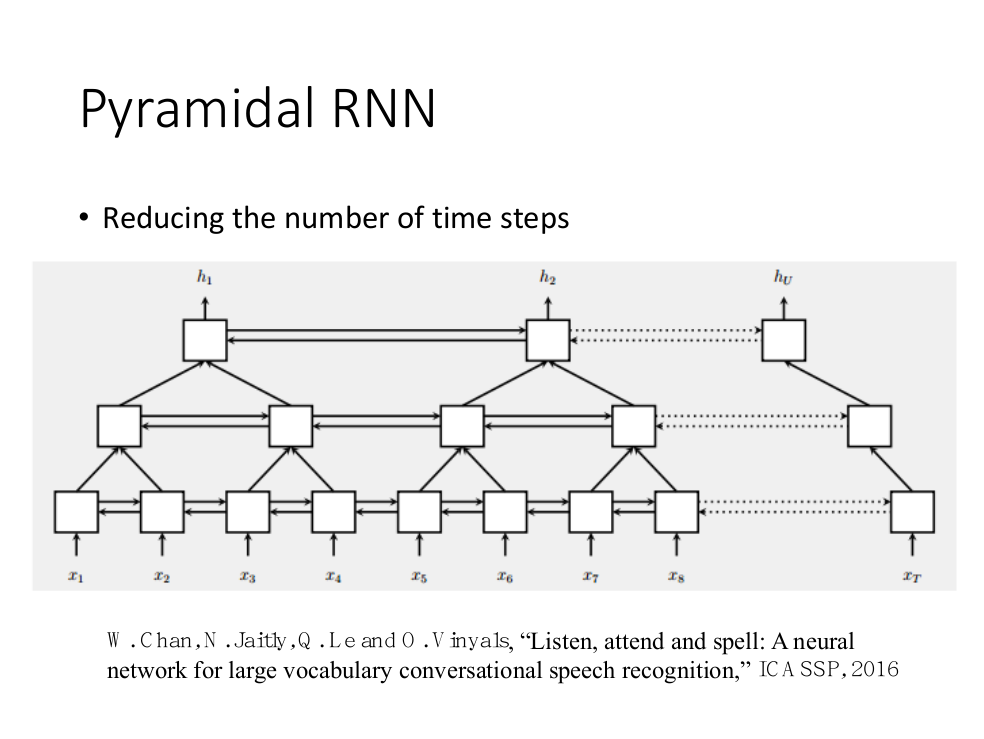

锥体RNN,好处是可以将sequence缩短。

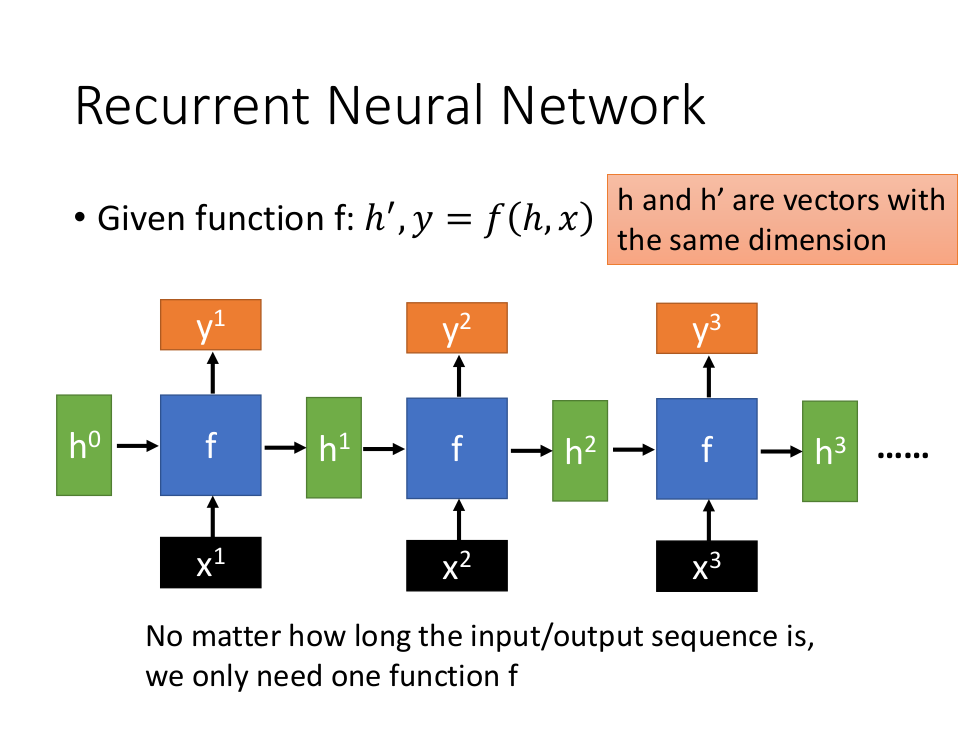

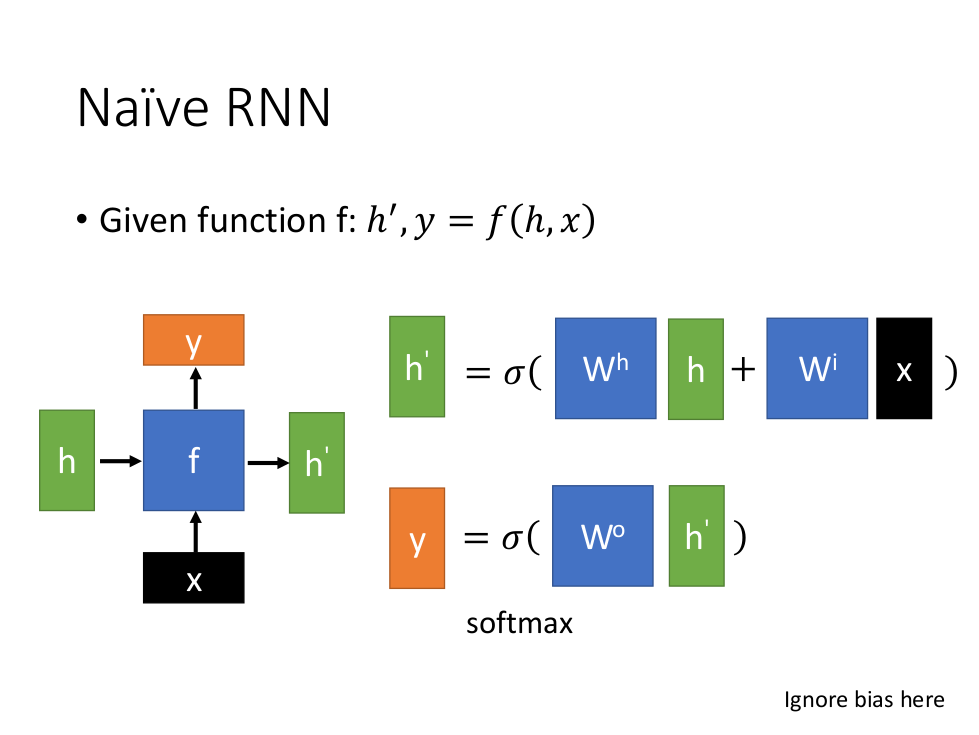

一个RNN的样子。其中y是从h’算出来的。(最简单的RNN)

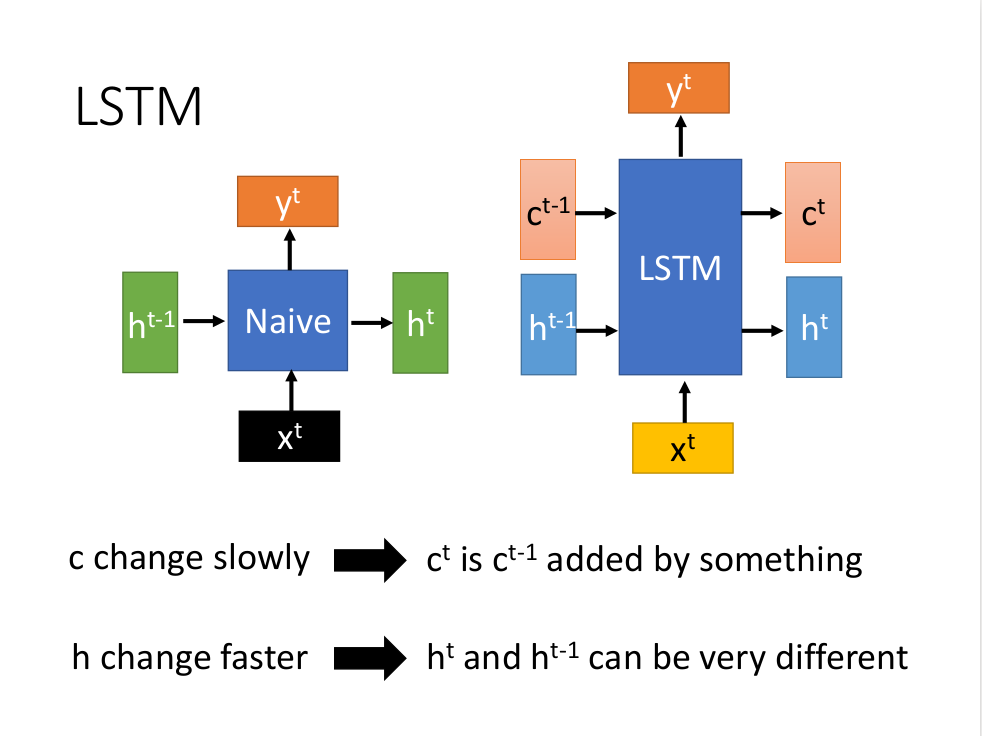

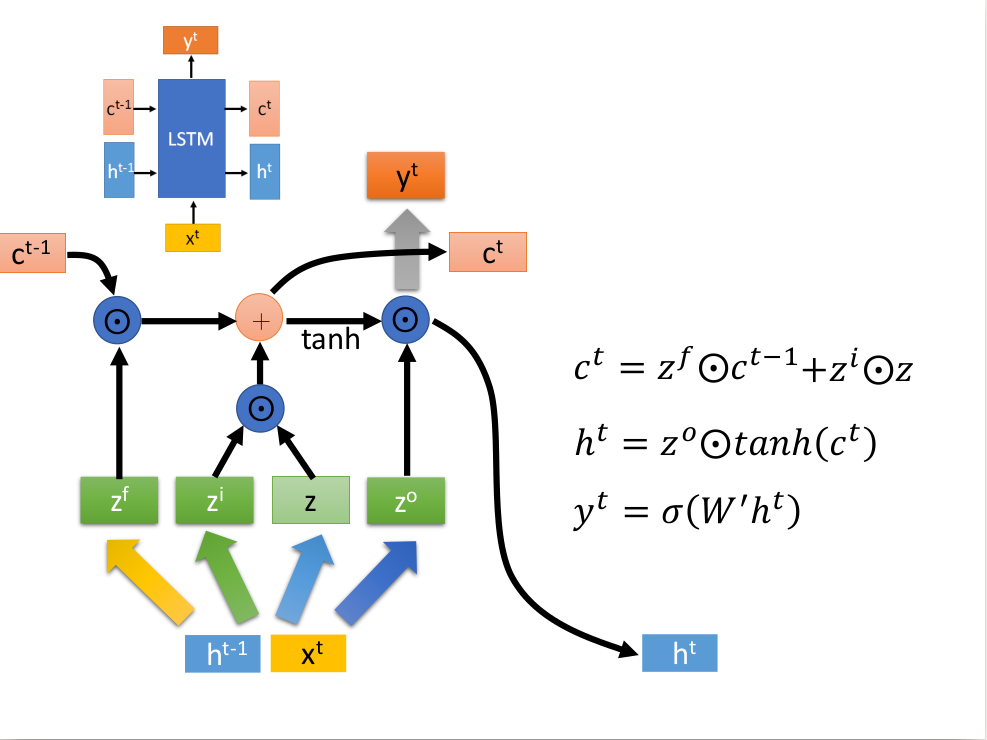

LSTM(长短时记忆网络)

(https://blog.csdn.net/jiede1/article/details/58595418)

$c^t$ 、$h^t$接其他的LSTM,LSTM的输入有两个vector,h是变化非常快的,而c变化较慢(记住以前的information)

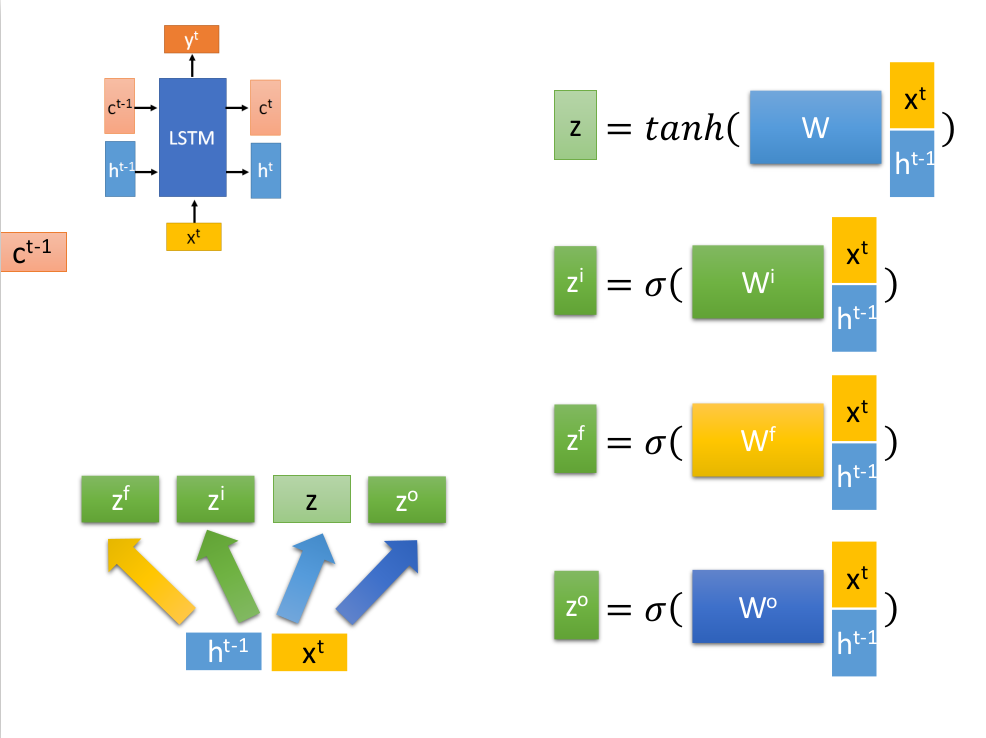

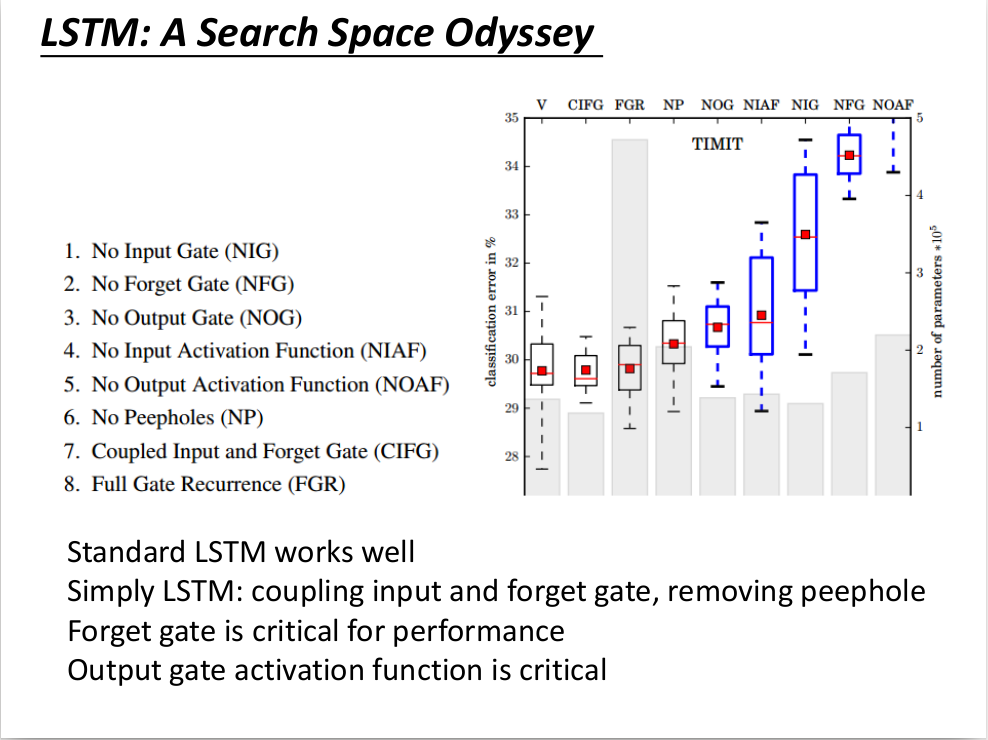

LSTM的架构,将$x^t$与$h^{t-1}$分别乘以不同的matrix.

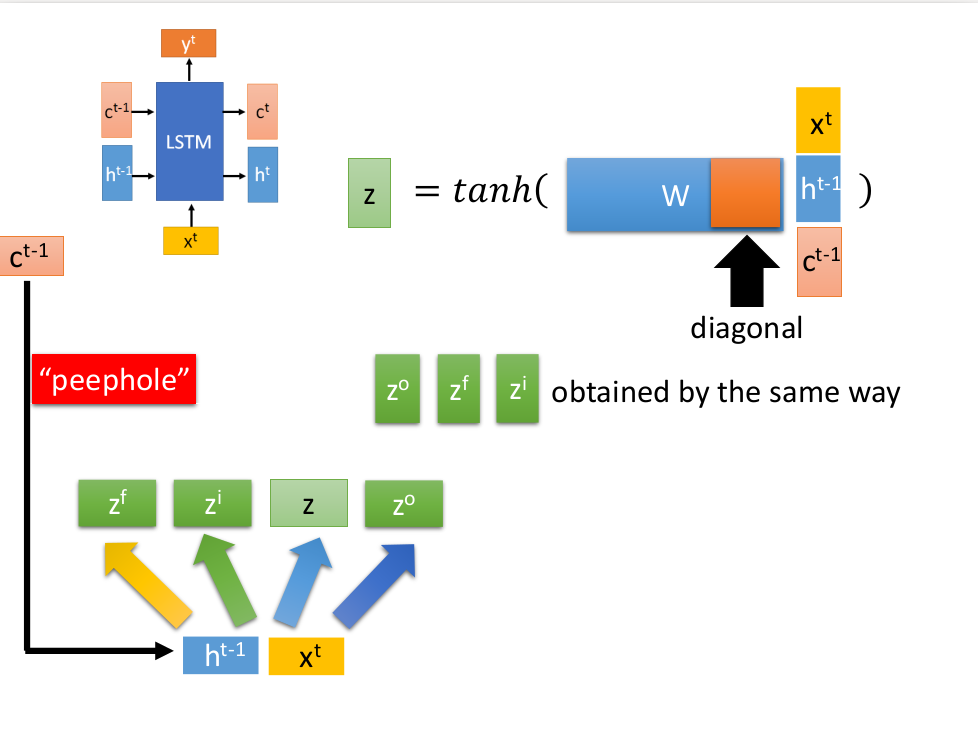

$c^{t-1}$的作用。

将$z^i$与$z$相乘,维度相同,再相加,得到$c^t$.

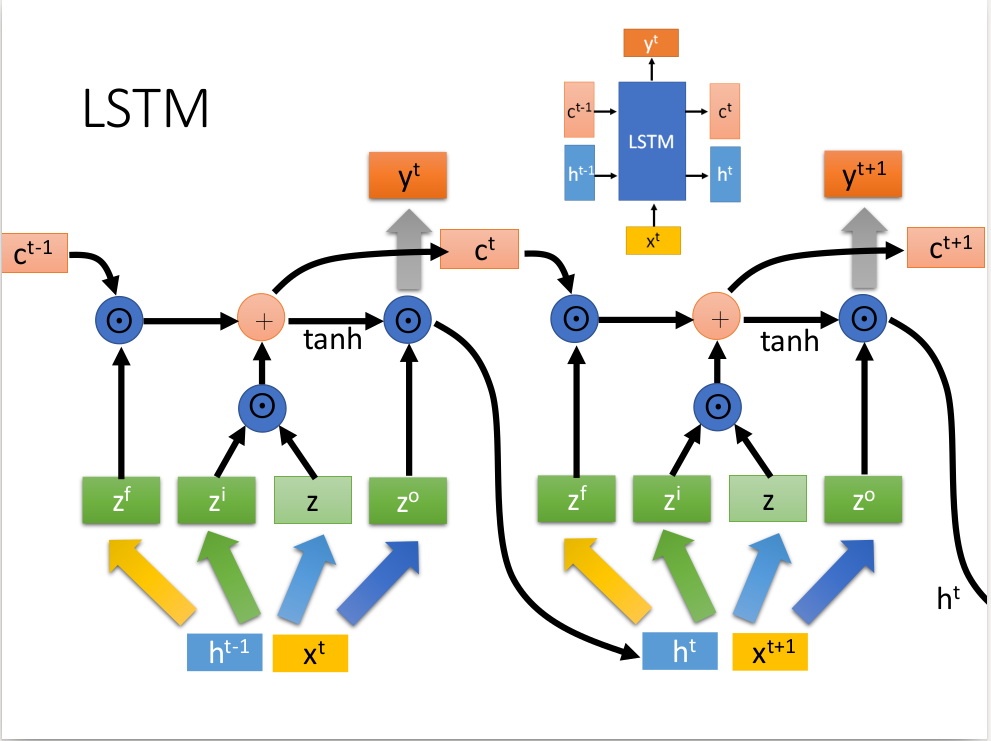

再次循环,反复使用。

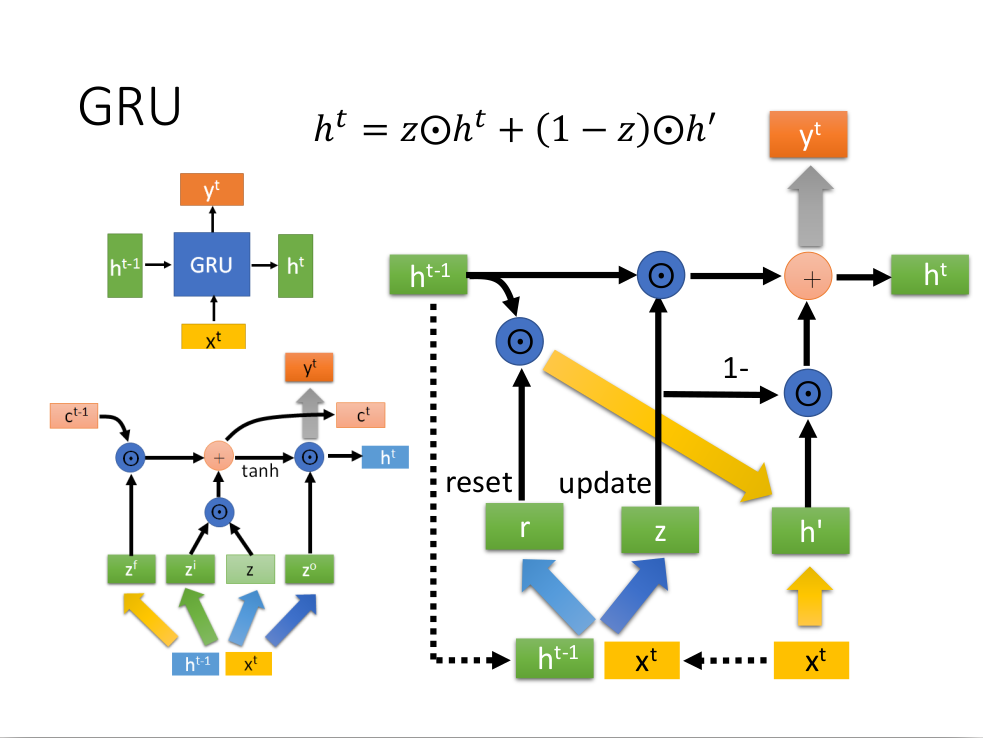

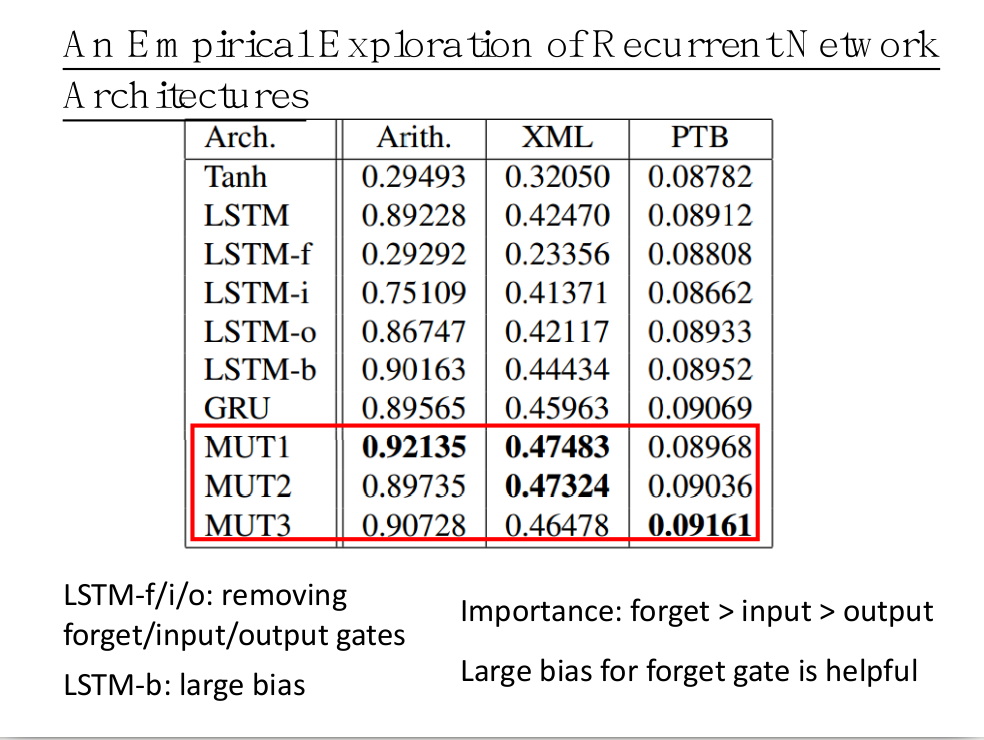

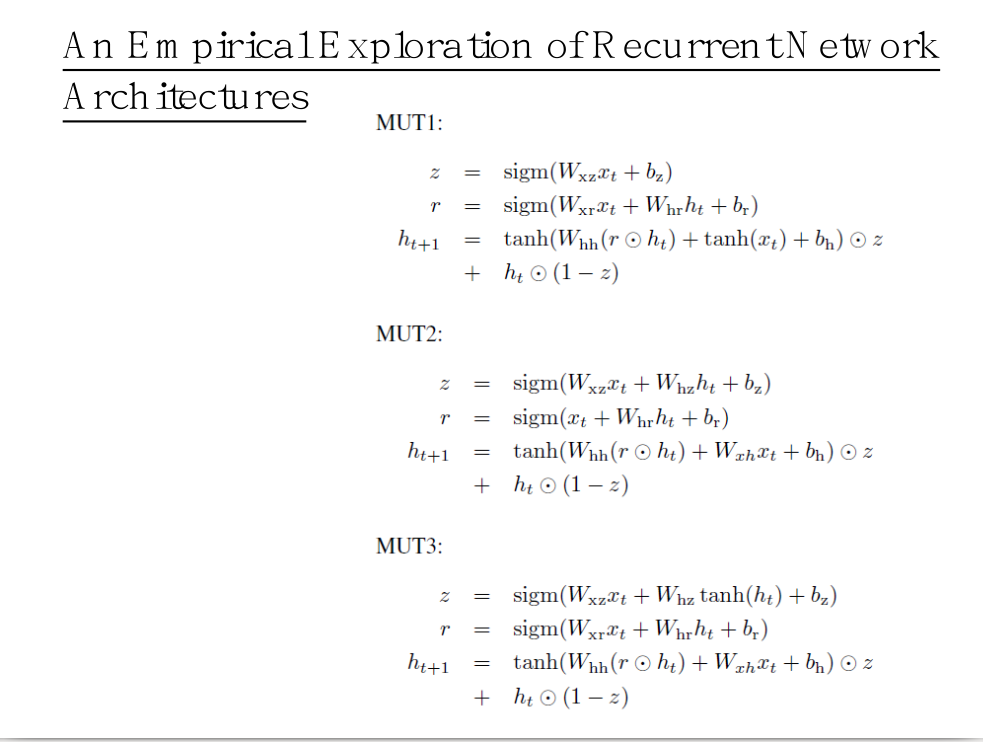

GRU

GRU不像LSTM有两个速度不一样的输入。出的箭头表示乘上了一个matrix,上面那个等式是$h{t-1}$,GRU的运算量比较小。

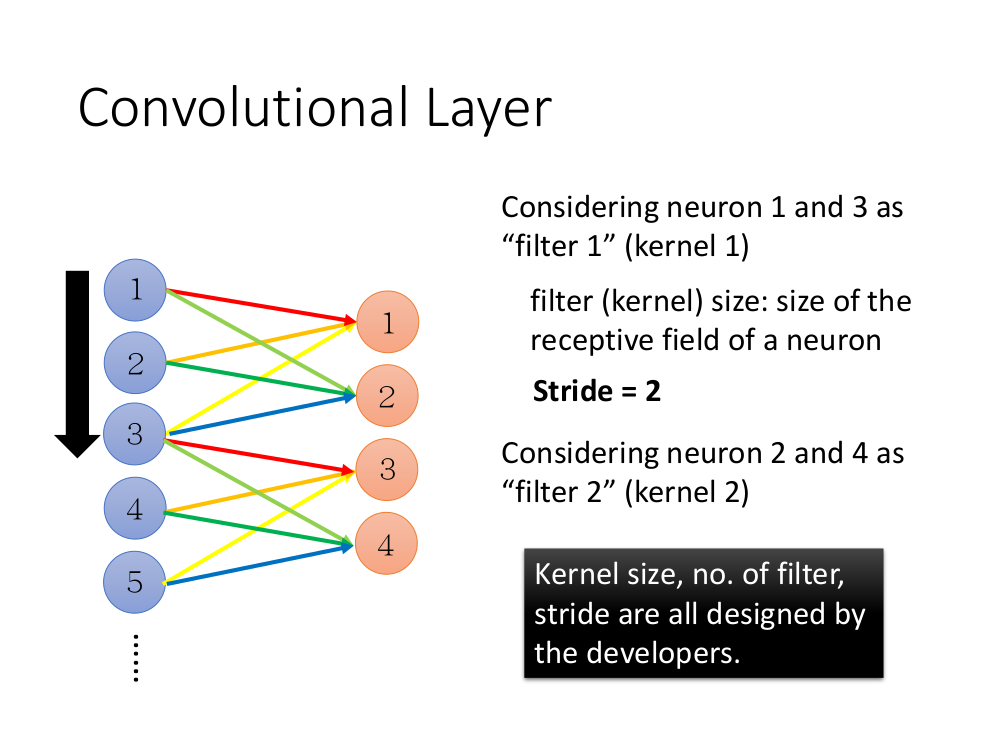

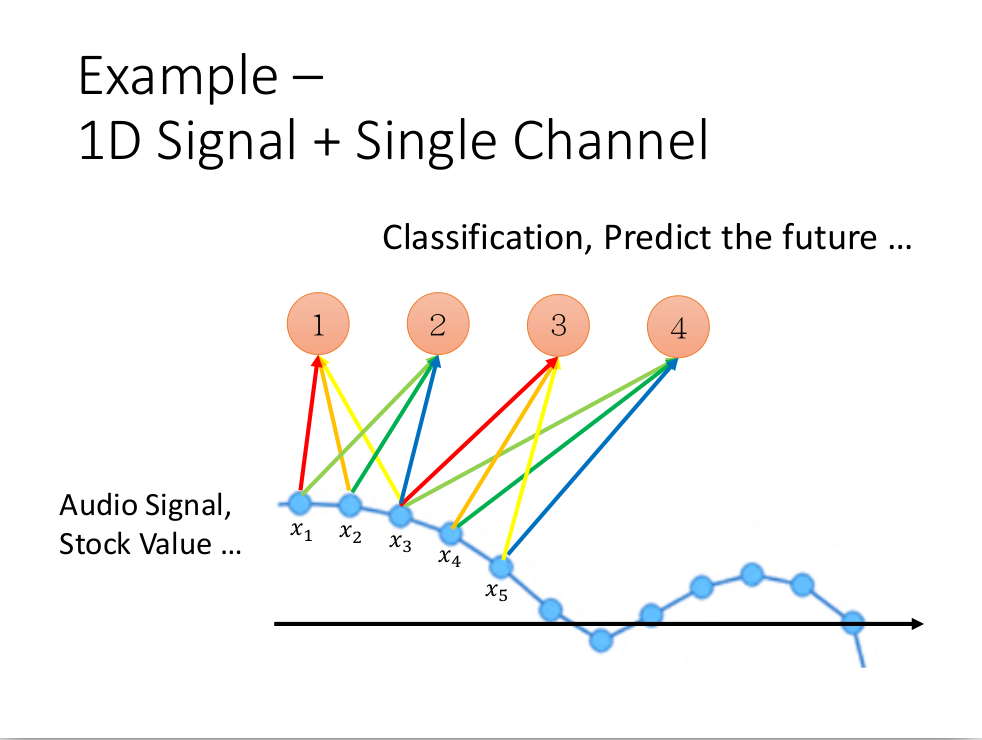

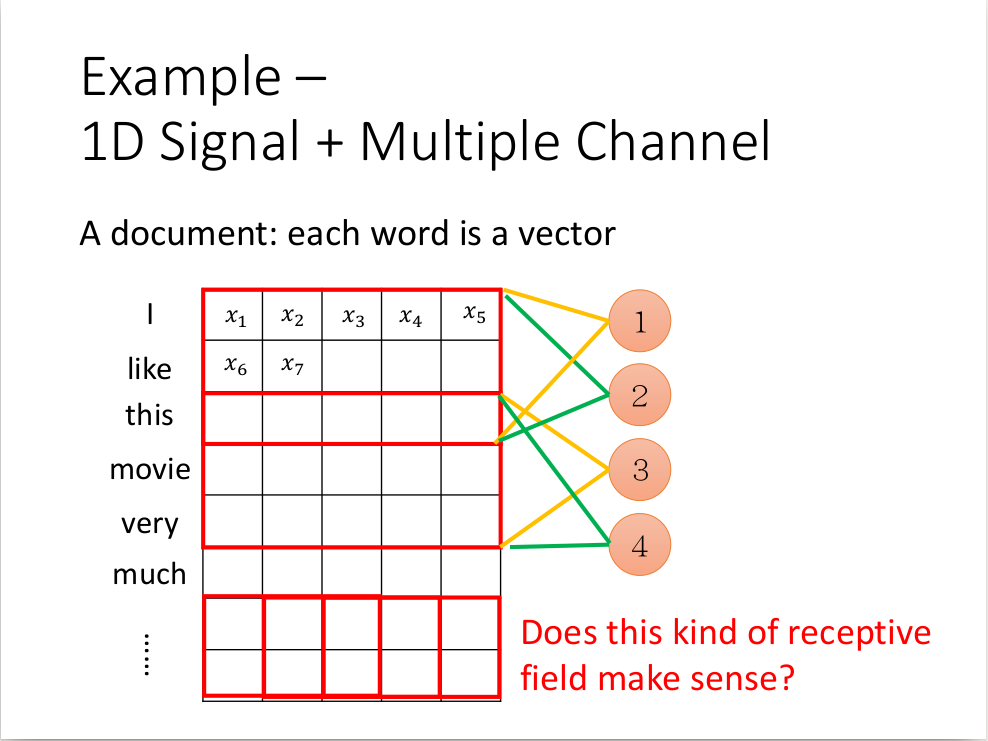

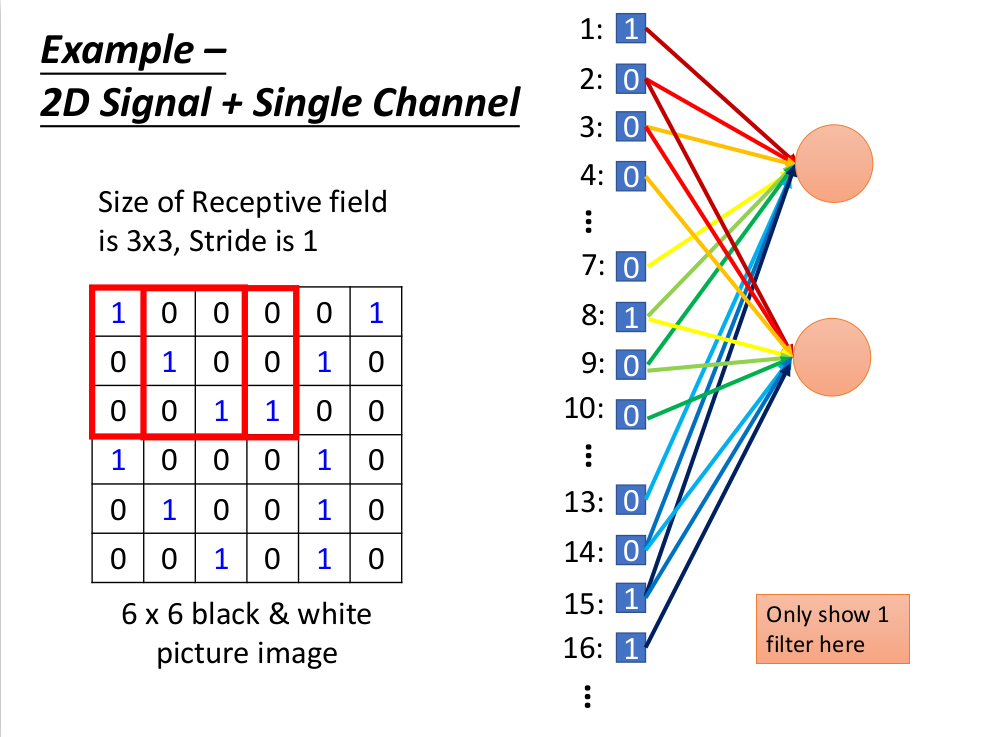

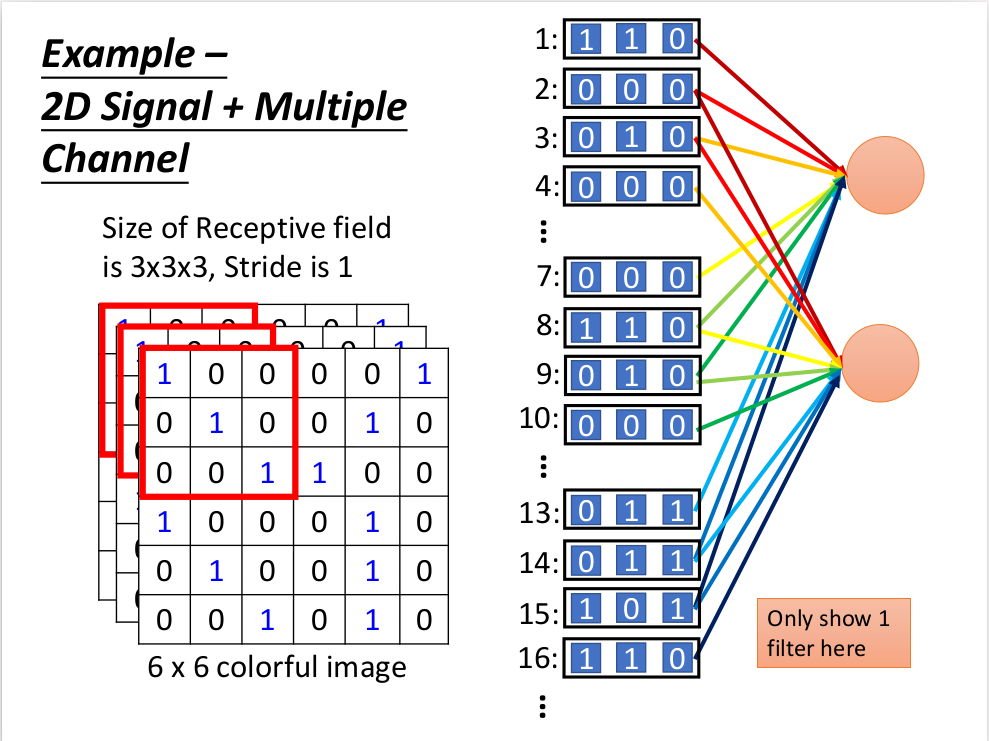

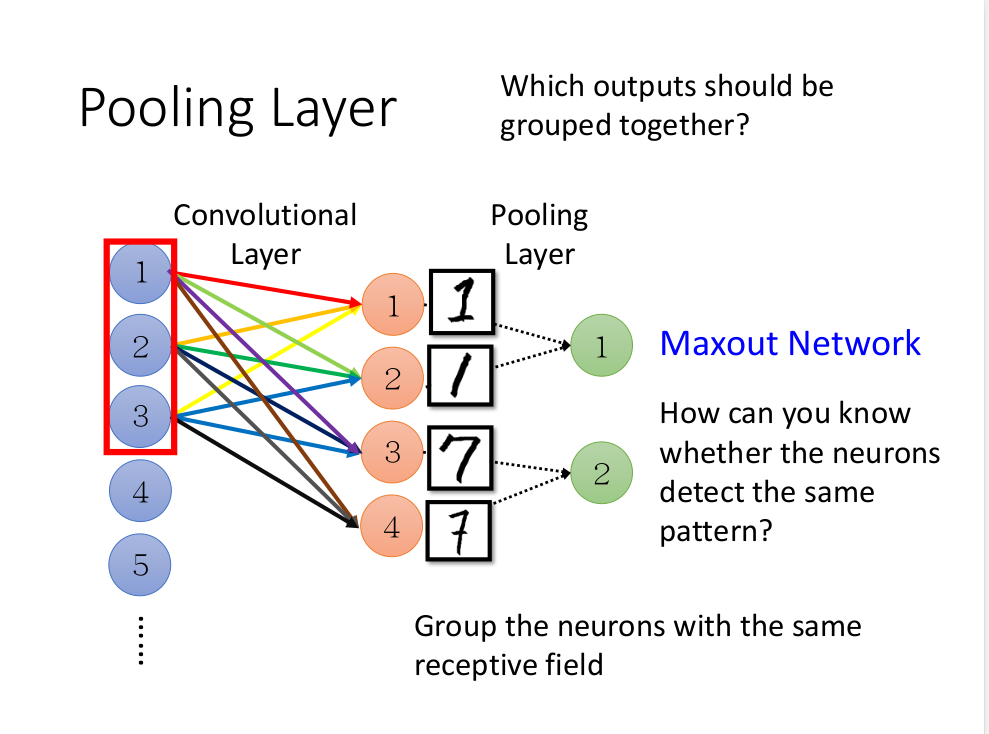

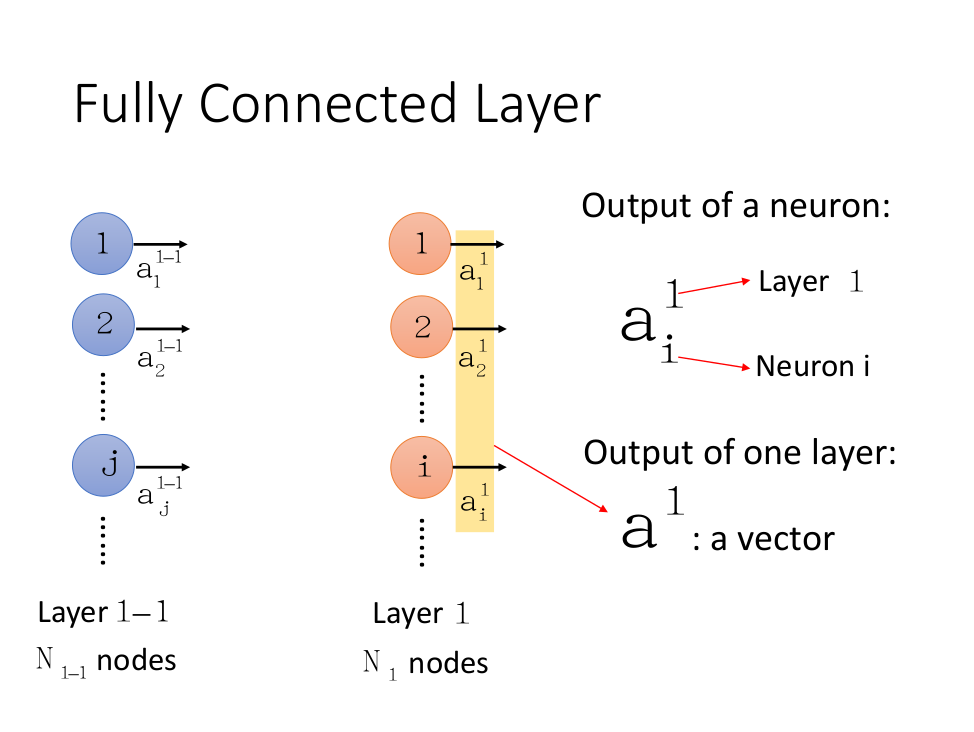

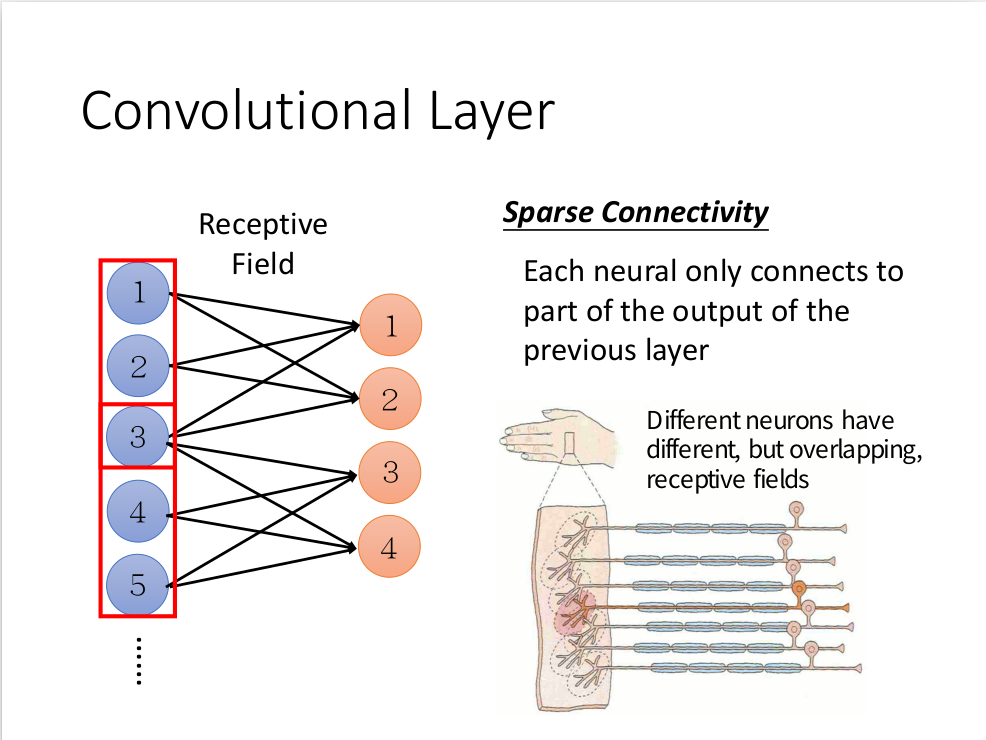

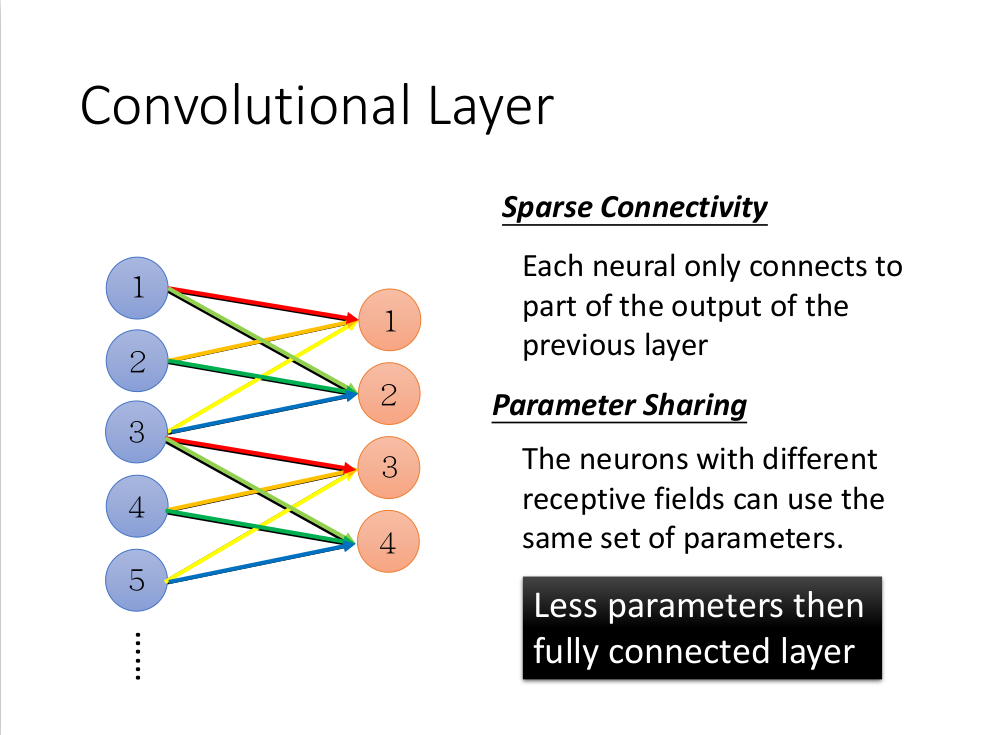

下一层只连接上一层的若干块。(每一个神经元只管皮肤的一小块部分)

不同的神经元可以有相同的参数(参数共享)